Публикую для объективности, хехе)

Рабочая формула сегодня: ИИ — не замена человеку, а мощный усилитель. Он требует постановки задач, инструментов, данных и человеческой проверки. Там, где это соблюдено, даёт значимый прирост скорости и качества; где нет — производит уверенный вздор.

Рабочая формула сегодня: ИИ — не замена человеку, а мощный усилитель. Он требует постановки задач, инструментов, данных и человеческой проверки. Там, где это соблюдено, даёт значимый прирост скорости и качества; где нет — производит уверенный вздор.

Коротко

Роджерс прав в общем скепсисе: современные модели ИИ ≠ человеческий интеллект, не имеют собственной воли/мотивации, ошибаются и требуют проверки человеком.

Но многие его формулировки чрезмерно категоричны: часть ограничений относится не к «ИИ вообще», а к конкретному классу систем (например, LLM без инструментов).

По пунктам

1) «ИИ — не интеллект»

Частично верно. Современные модели в основном предсказывают следующую «часть» данных (токен/действие) на основе статистики и не обладают самосознанием или человеческим «пониманием».

Но: они демонстрируют полезные когнитивные способности (обобщение, перенос, планирование в рамках задачи), чего достаточно, чтобы решать широкий спектр практических задач. Это «интеллект инструментальный», но не «субъектный».

2) «Мозг думает непрерывно; ИИ — только по запросу»

Верно как сравнение по умолчанию. Базовая LLM без обвязки пассивна: нет фона, снов, самопостановки целей.

Но: существуют агентные контуры (task loops, планировщики, наблюдатели), которые инициируют последующие шаги без участия человека. Это не «внутренняя мотивация», но практическая инициативность достигается инженерно.

3) «Инициатива и выбор тем»

Частично верно. Без внешнего триггера модель темы не «выбирает».

Но: автозапуск задач, подписки на события, мониторинги и правила позволяют системам самостоятельно подхватывать темы (всё равно это экзогенная, заданная программистами цель).

4) «Поиск информации слаб, нет прогулок по миру»

Частично верно. LLM сама по себе не ходит и не наблюдает мир.

Но: с инструментами модель умеет искать, читать, консолидировать источники, вызывать датчики/АПИ. Ограничение не фундаментальное, а архитектурное/операционное.

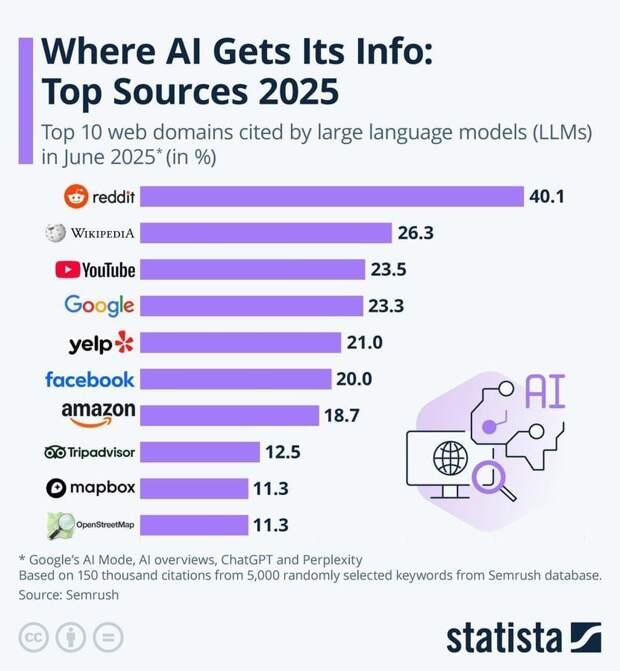

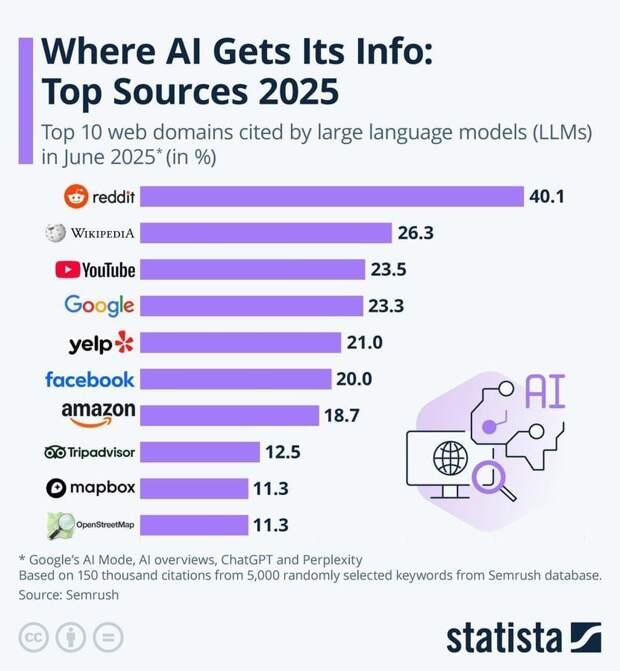

5) «Почти половина данных — с Reddit»

Недоказано/скорее неверно. Точные доли обучающих корпусов коммерческих моделей не раскрываются, а заявления о «половине» без источников — спекуляция. Известно лишь, что Reddit — один из множества крупных источников наряду с книгами, новостями, документами, кодом и пр.

А вот хрен! Доказано!

А вот хрен! Доказано!

6) «ИИ не различает правду и ложь»

В целом верно для «чистой» модели. Модель выводит правдоподобие текста, а не истину. Отсюда — галлюцинации.

Но: связка с инструментами (поиск, RAG, верификаторы, проверки ссылок) резко снижает ошибки. Полной гарантии нет, но «совсем не может» — преувеличение.

7) «Ему вручную прописывают, кому верить»

Преувеличение. Алгоритмы ранжирования и RLHF действительно формируют предпочтения по источникам и стилю ответов. Однако это не бинарное «верь X», а совокупность эвристик, политик и сигналов качества. И всё равно финальная проверка — задача пользователя/редактора.

8) «Не умеет отделять важное от неважного»

Частично верно. Важность для модели — не врождённая ценность, а функция цели.

Но: при заданной метрике полезности (целях, приоритетах, метатегах, векторных профилях) системы успешно ранжируют релевантность и приоритет обработки. Это уже рутинная практика.

9) «Работает с текстом, не с реальностью»

Верно по сути. Без датчиков/данных реального мира модель «заземлена» в текст.

Но: добавление данных из внешнего мира (телеметрия, базы знаний, таблицы, изображения, видео, сенсоры) даёт частичную «заземлённость». Всё равно требуется контроль качества.

10) «Систематически врёт (галлюцинирует)»

Верно как известная проблема. Галлюцинации — реальность.

Но: частота и тяжесть зависят от постановки задачи, промпта, инструментов, домена и проверки. С RAG/викификатором и строгими форматами она снижается до приемлемых уровней во многих прикладных сценариях.

11) «Нет критического мышления/картины мира»

Частично верно. Нет человеческой онтологии и личного опыта.

Но: модели формируют внутренние представления (латентные структуры), позволяющие ловить противоречия и объяснять выводы — пусть и не как человек. Плюс есть внешние «критики» (self-consistency, debate, verifier-модели), повышающие надёжность.

12) «Не напишет «Анну Каренину», не заменит творчество»

Оценочно и спорно. Уникальный художественный стиль великого автора — планка почти недостижимая.

Но: модели уже генерируют связные повести/сценарии, музыку и иллюстрации, проходящие слепые тесты «нравится/не нравится». Это иное творчество: комбинаторное, направляемое человеком-редактором. Полная замена автора — вряд ли; усиление автора — уже сейчас.

13) «Кодит на уровне “очень низком”»

Преувеличение. Производительность сильно зависит от задачи. В прикладном коде и тестах модели уже ускоряют работу разработчиков и решают типовые задачи на уровне джун/миддл при правильной постановке. Без человека качество падает, но как ускоритель они эффективны.

Итог

Где он прав: ИИ — инструмент без воли и опыта; без «заземления» и верификации часто ошибается; не обладает человеческим сознанием и мотивацией; хайп про «полную замену людей» — завышен.

Где перегибает: сводит всё к «текстовому процессору» и игнорирует связки с инструментами, агентные контуры, процедуры проверки; делает недоказанные заявления про источники (у меня есть пруфы, я просто не хотел перегружать текст - прим. Роджерса); категорично отрицает творческие и инженерные возможности, которые на практике уже полезны при человеческом надзоре (про надзор ключевое - прим. Роджерса).

Рабочая формула сегодня: ИИ — не замена человеку, а мощный усилитель. Он требует постановки задач, инструментов, данных и человеческой проверки. Там, где это соблюдено, даёт значимый прирост скорости и качества; где нет — производит уверенный вздор.

Свежие комментарии